26 octobre 2025

Temps de lecture : 5 min

GEO : c’est reparti pour les vendeurs de pelles

Cyrille Frank via Midjourney

Le Generative Engine Optimization est sur toutes les lèvres, à mesure que l’usage “search” se développe au sein des plateformes d’IA (chatGPT, Gemini et autres Perplexity).

Actuellement, cet usage reste minoritaire – quelque 8% de la population – même si beaucoup plus répandu chez les moins de 25 ans qui seraient 42% à l’utiliser tous les jours, dont à 92% pour de la recherche.

Ces chiffres sont indicatifs car aucun sondage ne donne le même chiffre, mais ils montrent néanmoins deux choses : l’usage progresse vite et il y a un décrochage générationnel.

La recherche conversationnelle, plus simple et personnalisée, est clairement dans le sens de l’Histoire. D’ailleurs, l’économie du clic est en déclin avec ces nouveaux moteurs de réponses nommées Google Overviews ou AI Mode.

Le nouvel eldorado : truster les LLM

Les agences de SEO – clairement en danger- turbinent pour défendre leur business.

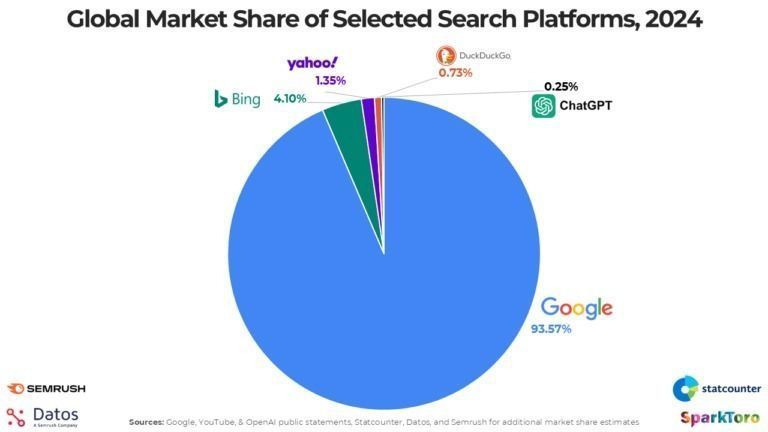

Au début, la ligne de défense était de minorer l’usage des plateformes IA qui représentaient un volume de recherches 373 fois plus petit que celui de Google en 2024 (c’est toujours très petit).

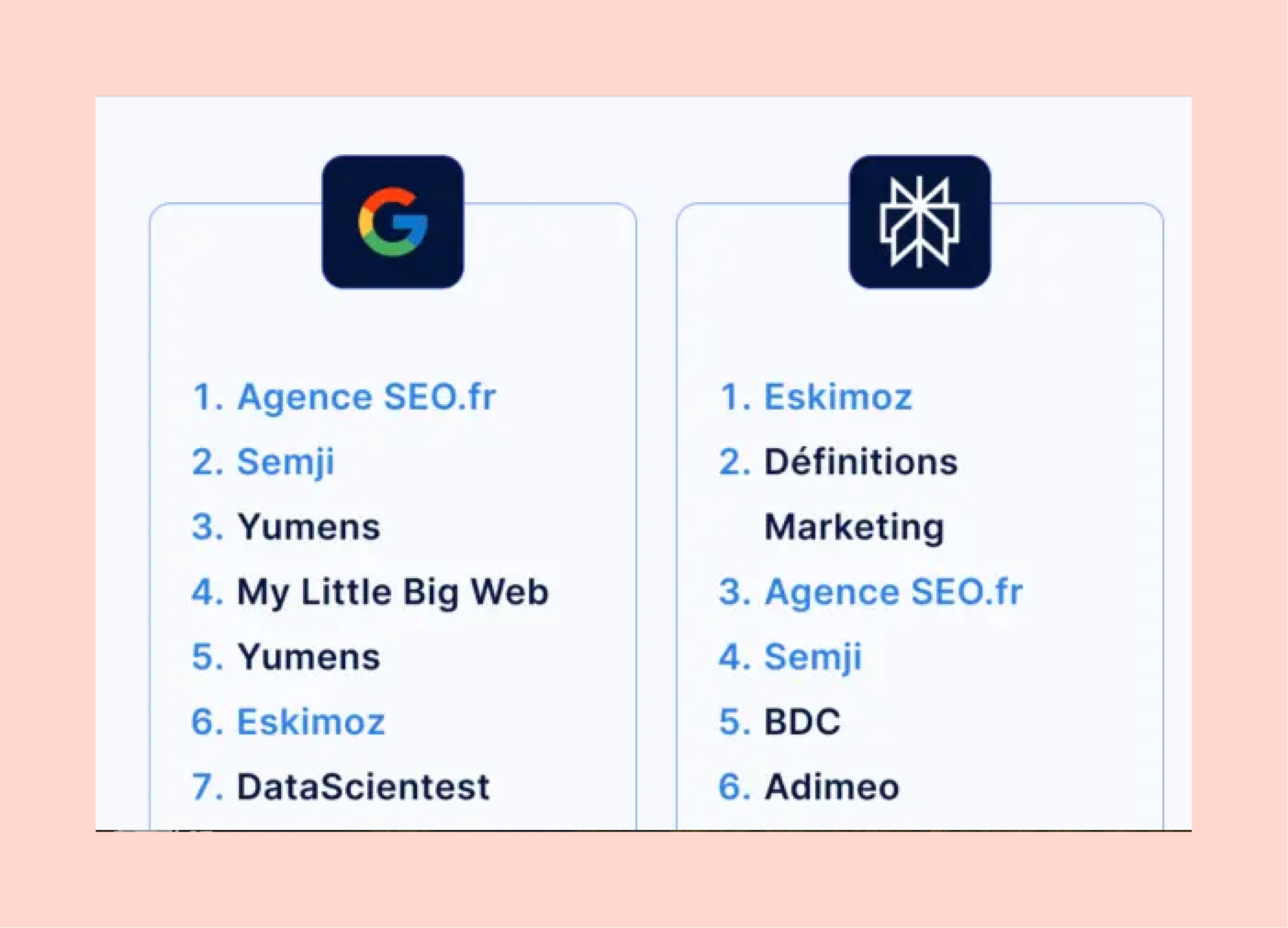

Ensuite, l’argument a été de dire que les marques bien référencées sur Google et Bing étaient bien référencées dans les plateformes IA. Andréa Bensaid, patron de l’agence Eskimoz se montrait optimiste, estimant que le SEO mutait un peu mais ne fléchissait pas.

Sauf que ce n’est plus le cas, semble-t-il, dixit la même source :

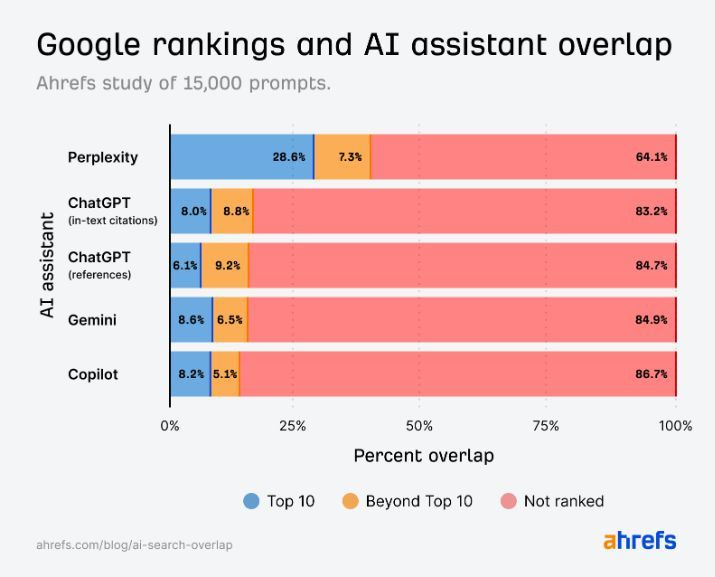

“9/10 des URLS citées par les moteurs de GenIA ne proviennent pas du top 10 Google. C’est dire la non porosité entre ces deux univers.” déclarait récemment Andréa Bensaid.

Aujourd’hui, le discours a donc encore changé. Les agences SEO et autres se positionnent désormais activement sur le GEO : comment être bien référencé dans les moteurs de réponse. Il fait dire que la trouille de perdre son trafic est très efficace : 90% des dirigeants et responsables marketing sont inquiets.

Les unes ou les autres vous promettent de bien figurer dans les réponses de ChatGPT, Gemini, Claude ou Le Chat grâce à des bonnes pratiques qu’ils ont identifiées :

- Travailler son autorité de marque

- Recourir aux format questions-réponses

- Utiliser des données structurées (schema.org)

- Soigner sa présence dans les moteurs

- Soigner sa présence dans les bases de données

Le groupe de presse Prisma Media Solutions a également lancé son offre payante de référencement des contenus sponsorisés sur les LLM. Reworld Media propose peu ou prou le même genre de service.

L’idée est de mettre la puissance et l’autorité de leurs marques média au service du GEO des annonceurs.

Sauf que tout ça ressemble beaucoup à du vent

Anis Ayari, ingénieur en IA n’y va pas avec le dos de la cuiller sur Twitter :

“Bon, désolé, ça ne va pas plaire à plein de vendeurs d’air, mais non, aujourd’hui il n’existe aucune méthode applicable, scalable et prouvée pour améliorer la recommandation de votre marque sur ChatGPT.

Parce que oui, surprise : il n’y a pas de réponse ni de solution générale. Ça va dépendre du contexte, de votre industrie, de la demande, etc. À terme, nul doute, comme en 2005, qu’on va commencer à voir émerger de gros patterns, mais ça viendra uniquement quand les providers (OpenAI, Google, etc.) fourniront des données, comme le search trafic (qui n’existe pas non plus aujourd’hui, malgré ce que certains acteurs veulent faire croire)”

Mark Williams-Cook, expert SEO américain partage le même avis et est même encore plus corrosif :

« Les outils de suivi du classement des résultats de recherche basés sur l’IA vous mentent. De nombreuses nouvelles entreprises de « visibilité par l’IA » vantent leurs produits, ce qui engendre de nombreuses idées fausses sur le secteur émergent de l’AEO ».

Il y a cinq raisons principales :

1. Personne n’a accès aux prompts des utilisateurs réels dans ChatGPT, Perplexity, Gemini, etc.

La mesure des classements dans les LLM n’est donc pas fiable, car elle se base sur les API, pas sur la réalité des requêtes effectuées par les usagers. Nous n’avons qu’un aperçu infime des requêtes réelles des utilisateurs et de leur popularité.

2. Presque tout le monde utilise des prompts « synthétiques ».

La plupart des outils de visibilité par l’IA génèrent des listes de prompts grâce à l’IA. Ils analysent votre site ou interrogent des sujets, puis génèrent des invites potentielles que vos clients pourraient utiliser.

3. Les outils analysent des prompts monotour (une seule commande), alors que les utilisateurs utilisent plusieurs commandes successives (multitour), via un dialogue avec le LLM.

Rien ne permet d’assurer que la marque citée au premier tour est toujours là au cours de l’échange avec l’IA.

4. Il y a une variation extrême des requêtes : les utilisateurs utilisent rarement des mots-clés simples comme « meilleures chaussures bleues », mais saisissent plutôt des phrases uniques, souvent grammaticalement variées. Même de légères différences dans une même invite peuvent entraîner des différences significatives dans les résultats.

5. La personnalisation forte des LLM exclut toute projection globale. La plupart des LLM, notamment ChatGPT, ont la personnalisation activée par défaut, ce qui adapte les résultats en fonction de ce que l’on sait de vous.

Mathieu Chapon, fondateur de Peak Ace, expert SEO/IA, résume bien toutes ces limites

Olivier Martinez, auteur de la newsletter IA-Pulse, lui, précise que la question de la structuration des données dans le code n’impacte pas le référencement. Seule compte la structuration visible des pages crawlées, comme en témoigne cette étude allemande.

Il ajoute que si les résultats apparents du GEO se rapprochent du SEO, c’est surtout parce que la plupart des LLM (à part Perplexity) ne possèdent pas leur propre crawler. Ils vont donc surtout aspirer les contenus des moteurs de recherche. Raison pour laquelle ce dernier a récemment y a mis fin il y a peu, en interdisant l’affichage simultané de plus de 10 résultats dans la search console.

En résumé : on ne peut pas du tout ni mesurer, et encore moins garantir un classement dans les LLM, à date. La manière dont cela fonctionne est assez nébuleux et en évolution constante. La présence de marque fortes tient aussi beaucoup aux accords passés avec les plateformes (comme Reddit ou Le Monde) qui leur garantissent une priorité d’affichage, ou des sortes de quotas.

Romain Prudent – qui porte bien son nom – s’est cassé dents sur une indexation de sa marque Veolia dans les LLM, malgré tous ses efforts pour appliquer toutes les bonnes pratiques recommandées. Avec beaucoup d’honnêteté il retient 4 enseignements :

1️⃣ L’humilité n’est jamais de trop face à la nouveauté.

2️⃣ Chercher à influencer les LLM est un formidable levier stratégique, mais c’est un chantier qui ne sera jamais fini.

3️⃣ Le monitoring ne peut plus être empirique : il doit devenir systématique.

4️⃣ Avec des modèles probabilistes, la mesure du succès n’est plus univoque : elle doit elle aussi intégrer une part de probabilité.

Le problème principal : on court encore derrière les plateformes

Plus globalement, on a le sentiment qu’on refait les mêmes erreurs qu’avec le SEO Google des premiers temps : on s’adapte aux contraintes et exigences techniques des géants, avant de penser à son produit éditorial et au client final.

Au début des années 2010, des gourous SEO nous expliquaient doctement qu’il fallait répéter le mot clé utilisateur dans le titre, le chapô, l’attaque de nos articles. Et tant pis, si c’était pénible pour l’utilisateur.

On nous demandait de mettre les liens sur des mots clés, car cela renforçait son Pagerank. Tant pis si l’utilisateur ne cliquait pas dessus, car il n’avait pas besoin qu’on lui donne la définition du mot-clé surligné.

Autant d’impostures que j’ai dénoncées alors. Et c’est la raison pour laquelle j’alerte depuis longtemps les éditeurs et marques sur une seule chose : soignez votre produit éditorial, votre communauté, vos recommandations avant tout. Et gardez-vous de suivre des recommandations techniques qui servent surtout les plateformes, pas l’usager final.

A lire aussi : IA dans les médias: gare à la surinflation de contenus bas de gamme

En résumé

- Le “search” conversationnel explose

Encore minoritaire (8 % des Français), il progresse vite, surtout chez les moins de 25 ans (42 % l’utilisent chaque jour). - Le SEO traditionnel vacille

Les moteurs d’IA (ChatGPT, Gemini, Perplexity) ne reprennent pas les mêmes résultats que Google. - Naissance du GEO (Generative Engine Optimization)

Les agences SEO se repositionnent pour “référencer” les marques dans les IA, en misant sur la notoriété, les FAQ et les données structurées. - Mais aucune méthode fiable n’existe

Les outils GEO sont jugés trompeurs : les experts dénoncent cinq biais majeurs : prompts artificiels, données limitées, absence de personnalisation mesurable et résultats très variables. - Retour à l’essentiel : le contenu :

Les marques doivent surtout soigner leur produit éditorial, leur communauté et leur valeur d’usage, au lieu de courir après les algorithmes des plateformes.

Topics

TOUS LES MATINS, RECEVEZ UNE DOSE D'ADTECH, D'EVENEMENTS, D'INNOVATIONS, MEDIA, MARKETING...

Je découvre les newsletters Minted !